En este vídeo pretendemos resumir las dos grandes líneas de trabajo que se impulsan desde de la Cátedra y que derivan directamente de su título:

https://youtu.be/ffy1gTNfQ0U

En este vídeo pretendemos resumir las dos grandes líneas de trabajo que se impulsan desde de la Cátedra y que derivan directamente de su título:

https://youtu.be/ffy1gTNfQ0U

Una empresa californiana llamada Smartstones ha creado un dispositivo que permite que las personas con dificultades para el habla puedan expresarse gracias a la lectura de las ondas cerebrales que son interpretadas y transformadas en frases a través de una aplicación móvil.

Una empresa californiana llamada Smartstones ha creado un dispositivo que permite que las personas con dificultades para el habla puedan expresarse gracias a la lectura de las ondas cerebrales que son interpretadas y transformadas en frases a través de una aplicación móvil.

El sistema aprovecha las ondas cerebrales que se generan cuando la persona que lleva colocado el dispositivo piensa en los movimientos que querría hacer para comunicarse.

Sin duda este tipo de dispositivos van a contribuir a mejorar la accesibilidad de las personas a todo un mundo de actividades y, estamos convencidos que, la enseñanza digital tiene que explotar su utilización al máximo. Además, su combinación con dispositivos de eyetracking abre todo un horizonte de posibilidades en este sentido.

Información e imagen tomada de este enlace.

Este es un ejemplo de interfaz cerebral barata, completa y abierta que se puede imprimir en 3D (ver http://www.microsiervos.com/archivo/tecnologia/interfaz-cerebral-barata-completa-abierta.html).

Este es un ejemplo de interfaz cerebral barata, completa y abierta que se puede imprimir en 3D (ver http://www.microsiervos.com/archivo/tecnologia/interfaz-cerebral-barata-completa-abierta.html).

Algunos trabajos de investigación empiezan a apuntar que esto es posible y cómo puede llevarse a cabo.

Recogemos una experiencia en la que, fundamentalmente,se utiliza una pequeña matriz de microelectrodos (de 4 x 4 milímetros) implantados en el cerebro capaz de registrar la actividad de la corteza motora correspondiente a los movimientos de un dedo imaginario y utiliza dicha información para controlar dispositivos externos (el ratón en este trabajo). La matriz estaba acoplada a un cursor neuroprotésico, de forma que los movimientos del mismo lograban ser más precisos y más rápido. Cuando los usuarios escribían (con el cerebro), llegaban a ‘teclear’ 115 palabras en menos de 19 minutos (seis por minuto). Mas información en Diario El Mundo y en la revista Revista Natura.

¿Será esta la base y la tecnología de la Interacción Persona-Ordenador de los sistemas del futuro? Por el momento, es conveniente dirigir investigaciones preliminares en esta dirección y veremos hasta dónde podemos llegar ya que todavía estamos lejos de este reto?

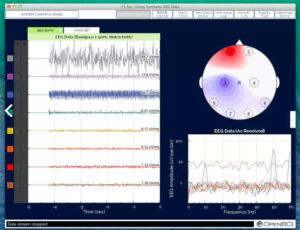

En esta Cátedra, hemos adquirido material para captura de información eléctrica del cerebro (casco EEG, amplificador de señal, software de registro, software de análisis) e incorporarlo al Laboratorio de Usabilidad en el Grupo CHICO. Esto nos permitirá utilizar técnicas de seguimiento ocular (eyetracking) y Brain Computing para trabajar en la dirección de:

– Desarrollo de dispositivos interactivos avanzados basados en Brain Computer Interaction y Wearable Computing.

– Realización de estudios de Usabilidad Tecnológica y Pedagógica.

EEG y recorder

Próximamente iremos mostrando y publicando la composición, configuración y aplicación del material adquirido.

Tal y como se recoge en el Diario El País, las emociones y sentimientos que genera los seres humanos ya se pueden traducir en un sonido audible. No suena igual la alegría más intensa que la pena más profunda. Lo saben bien los científicos del Centro de Regulación Genómica (CRG) de Barcelona que han desarrollado un sistema de comunicación pionero que convierte en tiempo real las ondas eléctricas que se producen en el cerebro en toda una orquesta polifónica según el tipo de emoción y la reacción que provoca en el cuerpo un determinado sentimiento. El dispositivo está pensado para «dar voz» a las personas con algún tipo de discapacidad motora que les impide comunicarse con facilidad con su entorno.

Tal y como se recoge en el Diario El País, las emociones y sentimientos que genera los seres humanos ya se pueden traducir en un sonido audible. No suena igual la alegría más intensa que la pena más profunda. Lo saben bien los científicos del Centro de Regulación Genómica (CRG) de Barcelona que han desarrollado un sistema de comunicación pionero que convierte en tiempo real las ondas eléctricas que se producen en el cerebro en toda una orquesta polifónica según el tipo de emoción y la reacción que provoca en el cuerpo un determinado sentimiento. El dispositivo está pensado para «dar voz» a las personas con algún tipo de discapacidad motora que les impide comunicarse con facilidad con su entorno.