Se supone que la influencia gravitatoria combinada del Sol y la Luna puede producir movimientos en la plantas, pero hasta ahora no se ha podido cuantificar ni entender el mecanismo subyacente, más allá de estimar que será un efecto de cambios en la gravedad de la superficie debido a la rotación de la Tierra. El artículo que comento precisamente demuestra, mediante datos obtenidos de experimentos previos realizados en la estación espacial y modelos analíticos, que la influencia de estos dos astros en el movimiento de las plantas se puede entender gracias a las inestabilidades de Rayleigh-Taylor debidas a cambios en la gravedad por al rotación en el sistema circulatorio de la planta.

Comienza la introducción del artículo diciendo que esta influencia gravitatoria sobre el movimiento de las planta está muy cuestionada, incluso hay quien la niega o considera que es sobre todo, un ritmo circadiano(1) esencialmente controlado por la luz u otro factor. Pero en este artículo demuestra la influencia del Sol y la Luna en los movimientos de las plantas, usando datos recabados del movimiento de plantas en la estación espacial como caso especial.

Para empezar, señala en la introducción que los movimientos de las plantas en la Tierra siguen un periodo de 24,8 horas, mientras que algunas plantas que se subieron a la estación espacial tenían un periodo de 45 minutos, cuando la rotación de la estación es de 90. Comentan que está demostrado que las modulaciones del campo gravitatorio de la Tierra debido a la acción del Sol y la Luna se ha demostrado que influye en el crecimiento de las plantas, y que puede llegar a ser percibido por otros seres vivos.

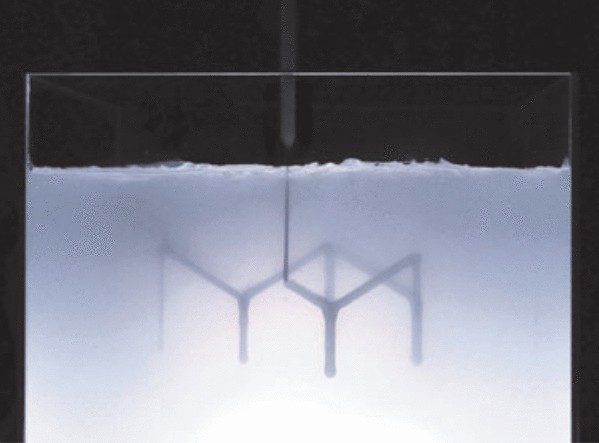

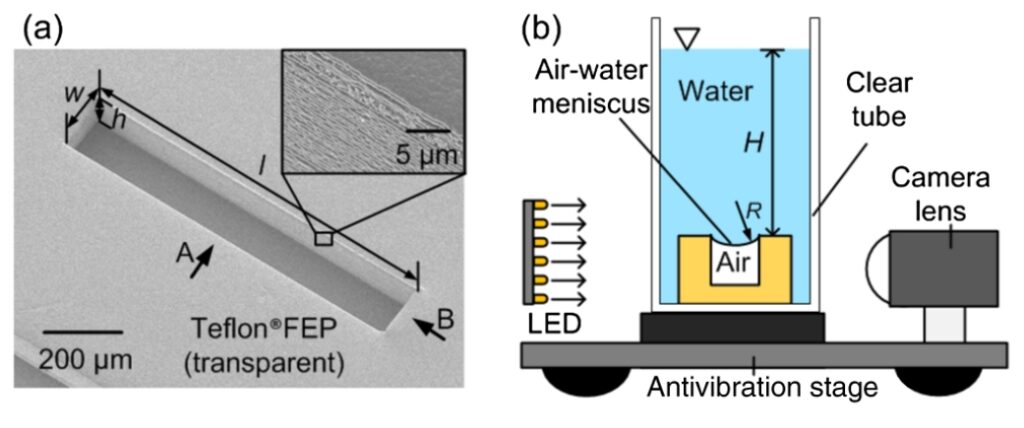

Para tratar de entender bien estos efectos, el autor del artículo desarrolló unos modelos simplificados del sistema circulatorio del las plantas, tubos microscópicos y de tamaño milimétrico, mesoscópicos, que contenían savia y un gas. En el artículo no lo especifica, pero tiene sentido que el gas sea aire atmosférico.

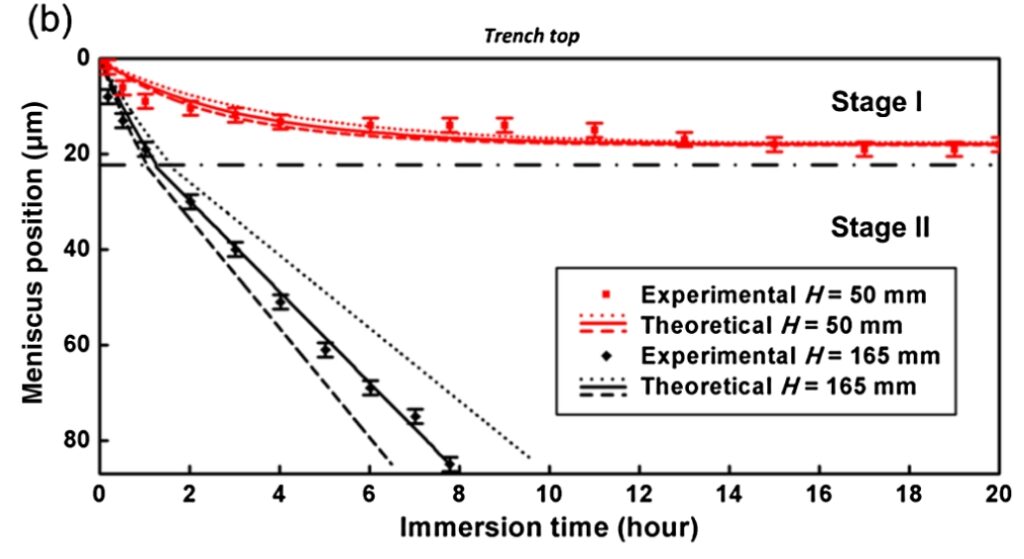

Para que la gravedad y la separación entre el líquido, la savia, y el gas pudiera tenerse en cuenta, estudió los tubos en horizontal y en vertical. Los tubos en horizontal serían equivalentes a las raíces de las plantas y los tubos en vertical, a los tallos.

Cuando los tubos están en horizontal, las raíces, debido al pequeño tamaño de los tubos empleados, la savia ocupa toda la superficie de los mismos, dejando el gas en el centro, de tal forma que hay una interfaz líquido-gas de simetría radial. En los tubos que hacen de tallos, debido a una ley denominada en el artículo como ley de Jurin(2) que relaciona la altura de un líquido por un tubo fino con su diámetro, se termina formando una interfaz líquido-gas en el punto de máxima altura de la savia.

Ambas interfaces líquido-gas se pueden estudiar como un caso especial de la inestabilidad de Rayleigh-Taylor, que el artículo afirma permite predecir, y demostrar con los datos experimentales de la estación espacial, la frecuencia de movimiento de las plantas, dado que el efecto más importante es el de la gravedad del Sol y la Luna a través de resonancias paramétricas asociadas con la variación de la gravedad.

Sigue el artículo con una sección que dedica a la estabilidad de las superficies líquido-gas en los tubos. Concretamente, plantea un modelo que permite definir las variaciones en la interfaz entre savia y gas para los tubos horizontales, despreciando los efectos a segundo orden y considerando que los dos fluidos son incompresibles y los efectos de la viscosidad despreciables. El resultado final es que las variaciones en esa interfaz líquido-gas tienen una frecuencia que se puede deducir de la ecuación que relaciona la diferencia de presiones entre líquidos y gas(3).

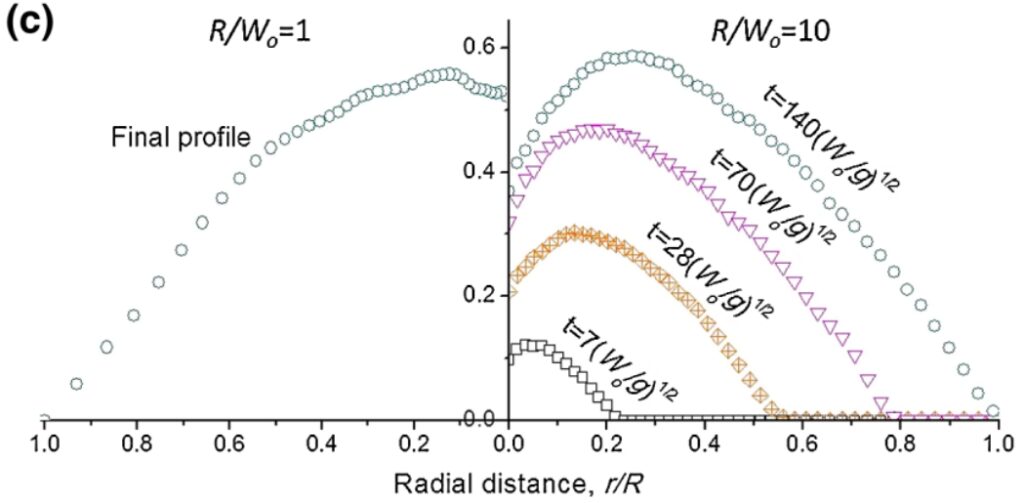

De esta ecuación se puede obtener una relación entre frecuencia de perturbaciones y magnitudes materiales del líquido y gas, densidad y viscosidad, que emplea en la sección siguiente para dar valores numéricos a las características de los fluidos, además de considerar qué fórmulas y modelos pueden emplearse según los tubos estén en horizontal o vertical en la Tierra o en al estación espacial.

En las dos secciones siguientes estudia las variaciones del valor de la gravedad en la Tierra y la estación espacial, dándole un valor numérico a la oscilación, que es pequeñísima, del orden de 1/ 8 000 000 en la Tierra.

En la sección siguiente comienza con una muy breve introducción a la ecuación de Mathieu, una ecuación diferencial que aparece con muchísima frecuencia en el estudio de la estabilidad de sistemas con cambios oscilatorios en algunas magnitudes. Luego, aplica las relaciones y formas anteriores a las resonancias que provoca la gravedad de la Luna y el Sol tanto en la Tierra como en la estación espacial en el valor de la frecuencia que aparecía en la ecuación de la diferencia de presiones de la interfaz. Así, logra demostrar que estas oscilaciones periódicas tienen las mismas frecuencias observadas en los movimientos de las plantas en los dos lugares, al comprobar como el periodo de las mismas coincide con el predicho según esta teoría de la inestabilidad de Rayleigh-Taylor, demostrando la influencia de la gravedad en los movimientos de las plantas.

Es enormemente curioso que los movimientos de las plantas tengan una relación tan estrecha con las oscilaciones tan pequeñas en la gravedad debidas a la Luna y el Sol, en función de la rotación terrestre. Mi corazoncito ciencaficcionero no puede por menos que notar que en otros planetas, con ciclos de rotación diferentes, estos movimientos de las plantas también serán muy distintos.

El artículo salió publicado en la revista Physics of Fluids, volumen 32: Phys. of Fluids. DOI:10.1063/5.0023717

(1) Ritmo circadiano: es el ritmo interno de las diversas variables que se midan en un ser vivo, desde composiciones químicas hasta periodos de actividad, asociadas a cambios externos. El enlace de la wikipedia en español es bastante ilustrativo: Wiki: Ritmo Circadiano

(2) James Jurin: Un médico londinense que efectuó estudios estadísticos muy importantes sobre la viruela, además de estudiar el efecto de la capilaridad en los líquidos. El artículo de la wikipedia en español es bastante bueno: Wiki: James Jurin

(3) No puedo poner bien la ecuación porque el sistema que empleo para escribir no tiene editor de ecuaciones. Malamente, la ecuación tiene la forma: d(p²)/dt^2 + w*p =0. Donde p es la diferencia de presiones y w la frecuencia.