Recientemente se ha publicado un artículo en la revista Science Robotics en el que se describe una prótesis con un recubrimiento que imita la piel humana, al menos en la transmisión de sensaciones de tacto y dolor, algo que hasta ahora estaba vedado a sistemas protésicos.

Comienzan explicando lo obvio: Nuestro sistema sensorial es fundamental para obtener información del mundo exterior, incluyendo por supuesto el sentido del tacto que, junto con nuestro propio sentido de nuestra posición(1), nos permite realizar tantas tareas cotidianas con nuestras extremidades, especialmente las manos.

Dentro de este sentido del tacto, la importancia del dolor es muy fuerte: nos permite saber si una superficie o algo que tocamos es seguro o no. Por eso ha habido una investigación muy intensa en los últimos años tratando de lograr algún tipo de retroalimentación sensora de las prótesis a sus usuarios, para lo cual se han seguido varios caminos.

Por ejemplo, se han publicado estudios con varios sistemas sensores capaces de proporcionar información sobre la posición de la prótesis al ususario, pero los avances más significativos han sido la demostración de la capacidad de proporcionar sentidos artificiales del tacto a amputados mediante electrodos implantados o simplemente en contacto con el cuerpo del paciente.

El avance fundamental de este artículo estriba en la inclusión del dolor como posibilidad a sentir desde una prótesis, lo que esperan que ayude a crear y diseñar sistemas más realistas y cómodos para los ususarios.

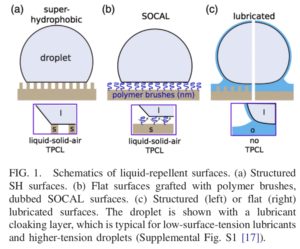

Para ello, desarrollaron dos sitemas distintos: una <<piel sintética>> con capacidad del sentido del tacto y una interfaz neuromórfica(2) que, combinados, dan al paciente la capacidad de sentir no sólo el tacto de lo que está tocando la prótesis, sino también de sentir dolor de la misma.

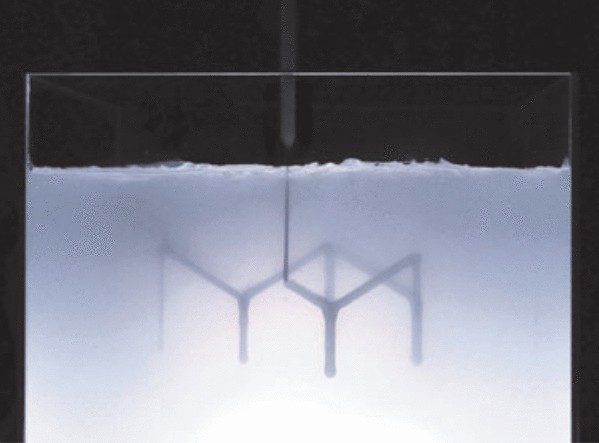

El esquema de funcionamiento se muestra en la siguiente figura:

La piel sintética funciona imitando la natural, con dos capas diferenciadas con distintas sensibilidades, que ayudan a poder percibir las formas de los objetos que se estén tocando.

Para ser capaces de darle retroalimentación de los datos de la prótesis al usuario, mediante el uso de cables intertados bajo la piel, TENS siguiendo sus siglas en inglés(3) proporcionaron estímulos al cerebro del paciente, para que el les dijera qué estaba <<sintiendo>> de su miembro ausente, es decir, qué regiones percibía como tocando algo (el dedo índice de la mano izquierda, el de la mano derecha, etc) de manera que elaboraron un mapa de qué estímulos le decían a su cerebro que estaban tocando el miembro amputado. Con ellos, podían engañarlo para decirle que un dedo estaba tocando algo, cuando en realidad producían la señal desde la prótesis.

Para imitar la percepción espacial de objetos, la piel artificial estaba dividida en partes discretas, de tal forma que según el número y situación de las partes de la piel activadas, el sistema de retroalimentación era capaz de mapear una forma del objeto que estaba siendo tocado y transmitirle esa información al paciente. Las diversas formas de distribuir la presión en los sensores para tres objetos muy diferentes las muestran los autores en su figura 4, que reproduzco:

Para terminar de mejorar el sistema, añadieron la capacidad de hacer percibir al sujeto dolor de la prótesis cambiando la frecuencia y duración de las señales que emitieron mediante TENS(3) a su cerebro, y además proporcionaron, a modo de prueba, un cierto sistema reflejo a la prótesis capaz de soltar aquello que le causaba dolor sin intervención consciente, de un modo muy similar a como funciona el sistema reflejo humano real.

El artículo original se puede encontrar en:

Prosthesis with neuromorphic multilayered e-dermis precieves touch and pain,

Science Robotics 20 Jun 2018. Vol. 3, Issue 19, eaat3818

DOI: 10.1126/scirobotics.aat3818

https://robotics.sciencemag.org/content/3/19/eaat3818

Notas:

(1) Llamado propiocepción, una características de los seres humanos que se considera ya un sentido como la vista, el oido, etc.

(2) Interfaz neuromórfica: Quieren decir un sistema de comunicación entre la piel y el usuario que imita el sistema neuronal humano.

(3) TENS: Transcotaneus Electrical Dermal Stimulation, Estimulación eléctrica dermal transcutánea.