En una investigación publicada en la revista ACS Nano en el año 2019, unos investigadores lograron emplear aerogeles(1) para poder generar temperaturas medias usando luz solar, cerca de 200 ºC, sin necesidad de concentrarla ni de sistemas de vacío.

Como ellos mismos explican en la introducción, debido al uso de combustibles fósiles por parte de la humanidad hemos cambiado lo suficiente la composición de gases de la atmósfera como para cambiar la capacidad de la misma de absorber y emitir luz solar, provocando su calentamiento. Lo que se suele llamar «efecto invernadero».

Pero este efecto no tiene porqué ser negativo si no calentamos toda la Tierra, pero sólo un volumen muy limitado y mucho más. En ese caso, tendríamos un sistema llamado termo-solar, capaz de calentar un volumen hasta temperaturas del orden de 120 o 220 ºC, que es muy útil en muchas aplicaciones básicas: calefacción, cocina, etc.

Hasta ahora, la mayoría de los sistemas de este estilo tenían bastante complejidad. La razón es que para poder usar la relativamente baja poca potencia del Sol sin concentrar (~1 kW/m²), se usaban concentradores solares. Pero estos dispositivos son caros y tiene que realizar un seguimiento de la posición del Sol para poder enfocar correctamente la luz. Y de hecho, según afirman en el artículo sistemas de última generación de este tipo demostraron su capacidad para generar vapor de agua. Pero todos estos sistemas están sujetos a las pérdidas producidas por los fenómenos de conducción, convección y radiación. Los aerogeles no tienen estos problemas, dado que apenas conducen el calor, no radian el infrarrojo por su estructura interna, que impide que con grosores considerables la radiación infrarroja pase, y al no ser un fluido no pueden transmitir radiación por convección, puesto que sus partículas no se mueven.

Por supuesto, en general, todas estas ventajas tiene un grave problema: su estructura interna los hace también muy poco transparentes, con altísimos coeficientes de dispersión de luz solar que impiden su uso como elementos fundamentales de un colector solar. Hasta ahora.

La clave está en modificar el tamaño de los nanogranos que forman el aerogel, reduciéndolo para aumentar su transparencia.

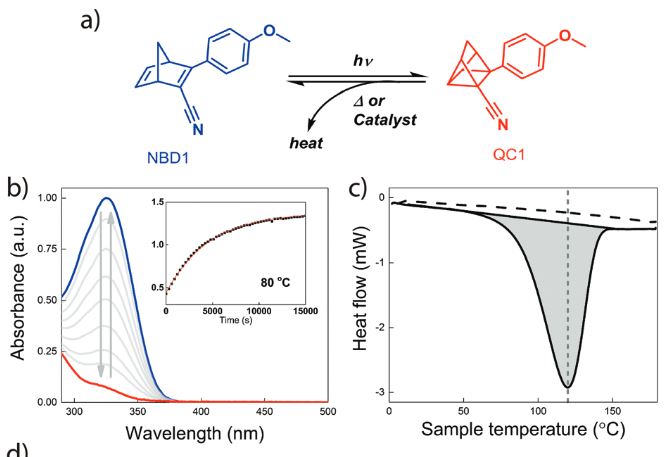

El artículo explica un poco el fundamento de los colectores solares, introduciendo para ello el concepto de «selectividad de invernadero»(2), es decir, como se observa en la siguiente figura, la capacidad de permitir el paso de las longitudes de onda del visible e impedir que circulen las longitudes de onda infrarroja.

Como se observa en la figura, si un determinado material permite que la luz visible pase a través suyo, mientras que impide el paso de la radiación infrarroja, con el tiempo se acabará calentando mucho más que el ambiente. Este proceso permitirá que el objeto situado justo debajo del material pueda transferir este calor. Los sistemas más habituales de lograr este material consisten en la modificación estructural y acumulación de diversas capas de materiales, todos ellos complicados. Por ejemplo, estrategias empeladas anteriormente, según cuentan en el artículo, han sido acumulación de múltiples capas de metal-conductor, cristales fotónicos(3) y otros.

Con el uso de los aerogeles, la selectividad de longitudes de onda se obtiene por la acumulación de volumen de material. El aerogel tiene permite el paso de luz solar, pero las longitudes de onda más largas del infrarrojo se ven dispersadas en volúmenes relativamente grandes del material, lo que provoca que no puedan atravesarlo.

La clave está en que lograron hacer un aerogel de baja dispersión y alta transparencia para la luz visible. Como explican en el artículo, debido a su estructura interna nanoporosa y la falta de movimiento de sus partículas, son grandes aislantes, dado que eliminan a la vez la posibilidad de conducción por el sólido, por los nanoporos, y la convección gaseosa, por la falta de movimiento de los mismos. Sin embargo, esa misma estructura provoca que los aerogeles normales dispersen una gran cantidad de luz visible y ultravioleta, dándoles su característico color azulado.

Lo cierto es que la dispersión de la luz visible se debe sobre todo al tamaño de los nanoporos del aerogel, mientras que la falta de transmisión del infrarrojo se debe a su densidad, ofreciendo la oportunidad que los autores del artículo aprovecharon, de ajustar una sola independientemente.

Para poder modificar el tamaño de los poros del aerogel, tuvieron que desarrollar una nueva manera de sintetizar el material, mediante modificaciones de la composición de los disolventes que emplearon. El resultado final es que su aerogel tiene una transmitancia del 95% con 10 mm de ancho.

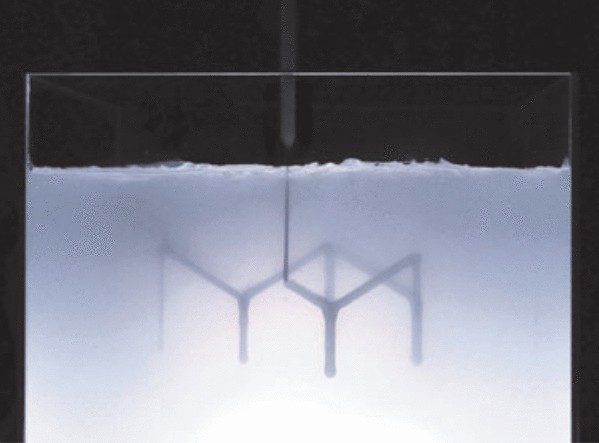

Con este material construyeron un prototipo de convertidor solar que está esquematizado en la siguiente figura:

Con esta estructura lograron una temperatura estable máxima, que la temperatura por debajo de la cual se puede extraer calor, de 265 ºC. Este valor es unos 100 ºC más alto de lo que se puede conseguir con aerogeles no optimizados y comparable a otro tipo de convertidores, con sistemas de vacío y superficies muy complicadas. Para comprobar como funcionaba en condiciones de campo, hicieron un pequeño sistema que obtuvo los resultados de la siguiente figura:

El artículo original se titula «Harnessing Heat Beyond 200°C fromUnconcentrated Sunlight with NonevacuatedTransparent Aerogels» y se puede encontrar en: ACS Nano 2019, 13, 7, 7508–7516

(1) Aerogel: Sustancia coloidal similar a los geles más habituales, donde se sustituye el líquido de los geles por un gas, proporcionando un material muy poco denso, pero extraordinariamente resistente tanto al calor como a la tensión. Se pueden hacer de varios compuestos base, pero en este artículo, su base principal es el Silicio, debido a las propiedades ópticas que se alcanzan.

(2) Así lo traduje yo. EL artículo en inglés habla de «Greenhouse selectivity».

(3) Cristales fotónicos: Estructuras de tamaño nanométrico que alteran la reflectividad y transmisión de la luz a través suyo debido a su pequeño tamaño. en la Wikipedia en inglés: Photonic Crystal.