Los vidrios(1) son materiales muy útiles para el ser humano. Son duros, impermeables, suelen ser resistentes a los ataques químicos de muchas sustancias, se pueden reciclar con facilidad, por no mencionar su transparencia a la luz visible, que los hace tan útiles en la formación de lentes y elementos del estilo.

Pero tiene algún problema, el principal su fragilidad. Son muy duros, por eso aguantan muy bien grandes tensiones, pero son frágiles: cualquier golpe lo hace romper. Otros sustitutos más flexibles, como el plástico, son maleables, pero blandos y no aguantan grandes temperaturas.

Recientemente, un grupo de científicos ha conseguido crear un material que combina características tanto de plásticos transparentes como de vidrios: es muy duro y transparente a la vez. Usando una mezcla de polímero metacrilato y láminas planas de vidrio de tamaño micrométrico han creado un compuesto que han denominado «compuesto nacarado» por la similitud de sus propiedades mecánicas con el nácar natural.

Los investigadores se fijaron en el nácar por sus propiedades mecánicas: es unas tres mil veces más duro que los elementos que lo forman y tiene una resistencia a la fractura también muy alta. Comentan también que con la intención de copiar la estructura del nácar para su uso industrial, varias técnicas se han implementado, desde la aplicación de películas delgadas hasta su infiltración con polímeros entre láminas de cristal. También se ha intentado formar estructuras en el cristal que imiten la del nácar empleando láseres u otros métodos, pero son sistemas muy caros y de difícil escalibilidad industrial.

Así, en su investigación los autores tenían que lograr dos objetivos distintos en el material que crearon: tener una parte dura y muy poco flexible, muy unida a otra parte flexible y deformable. Además, para que la transmisión de luz fuera buena, el índice óptico de ambas partes del material deberían coincidir lo mejor posible. Por eso emplearon vidrios transparente como componente duro y metacrilato como componente blando. El problema es que, si bien el metacrilato es transparente, no tiene el mismo índice de refracción del vidrio, con lo que el conjunto no sería muy transparente. Pero lo pudieron solucionar añadiendo un dopante al metacrilato que alteró su índice de refracción hasta hacerlo muy similar al del vidrio, algo que ya estaba resulto previamente.

De todas formas, el tener los materiales no es el final de la historia: también hay que lograr que la estructura de la mezcla sea la adecuada. Para ello, los vidrios los añadieron en forma de láminas, para imitar la forma que tiene el nácar de láminas pegadas con el material más blando. Y claro, también tuvieron que lograr que vidrios y metacrilato se pegaran bien. Para ello, prepararon las láminas de vidrio con compuestos que alteraron su superficie para favorecer su mezcla con el metacrilato. Luego, para que el producto mezclado adoptara la forma adecuada, lo centrifugaron(2) de forma que las tablillas de vidrio y el metacrilato adoptaron la forma de los ladrillos y el cemento en una pared. Después, polimerizaron el metacrilato mediante tres etapas de calentamiento.

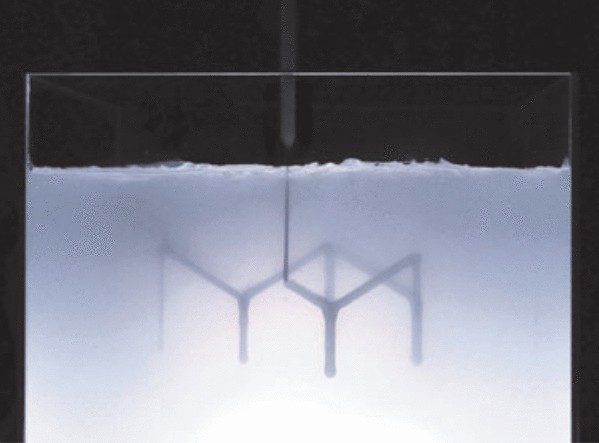

El resultado, después de dopar el polímero, fue un material con una transparencia muy parecida a la de cualquier vidrio incluido el comercial(3) como se observa en la figura siguiente, que muestra su transparencia de una manera muy visual.

Por otra parte, además de verlo de una manera tan visual, lo midieron directamente. Es decir, comprobaron la trasmitancia de la luz en las longitudes de onda del visible, de 400 a 700 nm, de este material y lo compararon con vidrios y otros intentos previos de otros investigadores. Como muestra la figura siguiente, su material tiene propiedades muy similares al vidrio comercial en las longitudes de onda visibles.

Por otra parte, si este material tiene que sustituir al vidrio, también tiene que ser fuerte. Idealmente, debería tener mayor flexibilidad para convertirse en un «vidrio flexible». En el artículo resaltan la importancia del centrifugado, dado que logra concentrar y ordenar las placas de vidrio de tal forma que su estructura interna se hace más resistente sin perder demasiada flexibilidad, como indica la figura siguiente.

Para terminar el artículo los autores comparan su material en el diagrama de Ashby(4) compuesto con la resistencia a la fractura y la tensión, donde claramente su material se compara muy favorablemente con varios materiales comerciales actuales, como muestra la figura siguiente:

El material que han logrado es impresionante: puede competir con varios vidrios artificiales, siendo mejor que ellos y es transparente en la luz visible. La verdad es que sería un material maravilloso para parabrisas y ventanas, que serían mucho más resistentes.

El artículo se publicó en la revista Science: Science, Vol. 373, Nº 6560. pp. 1229-1234 • DOI: 10.1126/science.abf0277.

Notas:

(1) Aunque a veces se los confunda, «cristales» y «vidrios» son cosas muy distintas para los físicos y otros científicos. Un cristal es un material cuya estructura interna es la repetición de unidades iguales, llamadas celdas, con una geometría muy bien definida. Por ejemplo, un cubo, una pirámide, etc. Los vértices de las figuras son los lugares ocupados por los átomos y la configuración es debida a las fuerzas entre los átomos. Un vidrio es un material cuya estructura interna no esa tan bien definida, es mucho más amorfa. Las entradas en la Wikipedia en Español lo explican bastante bien: Wiki:Cristal y Wiki:Vidrio.

(2) Es decir, lo mezclaron dándole vueltas a muy alta velocidad.

(3) En inglés se llama soda-lime-glass.

(4) Los diagramas de Ashby son gráficas donde dos propiedades relacionadas de un material se colocan como ejes para poder comparar mejor las ventajas y desventajas de su uso. El artículo en Inglés de la Wikipedia sobre selección de materiales lo explica muy bien: Wiki: Material Selection.